GLM-5 code 能力远不止简单的代码生成。借助 OpenAI 兼容 API、Function Calling 支持、并行工具执行和出色的 SWE-bench 分数,GLM-5 专为需要可靠性、编排和多步执行的生产编码工作流而构建。本文覆盖如何将 GLM-5 code 能力集成到你的开发管线中,以及真实使用中可以期待什么。

GLM-5 Code 性能概述

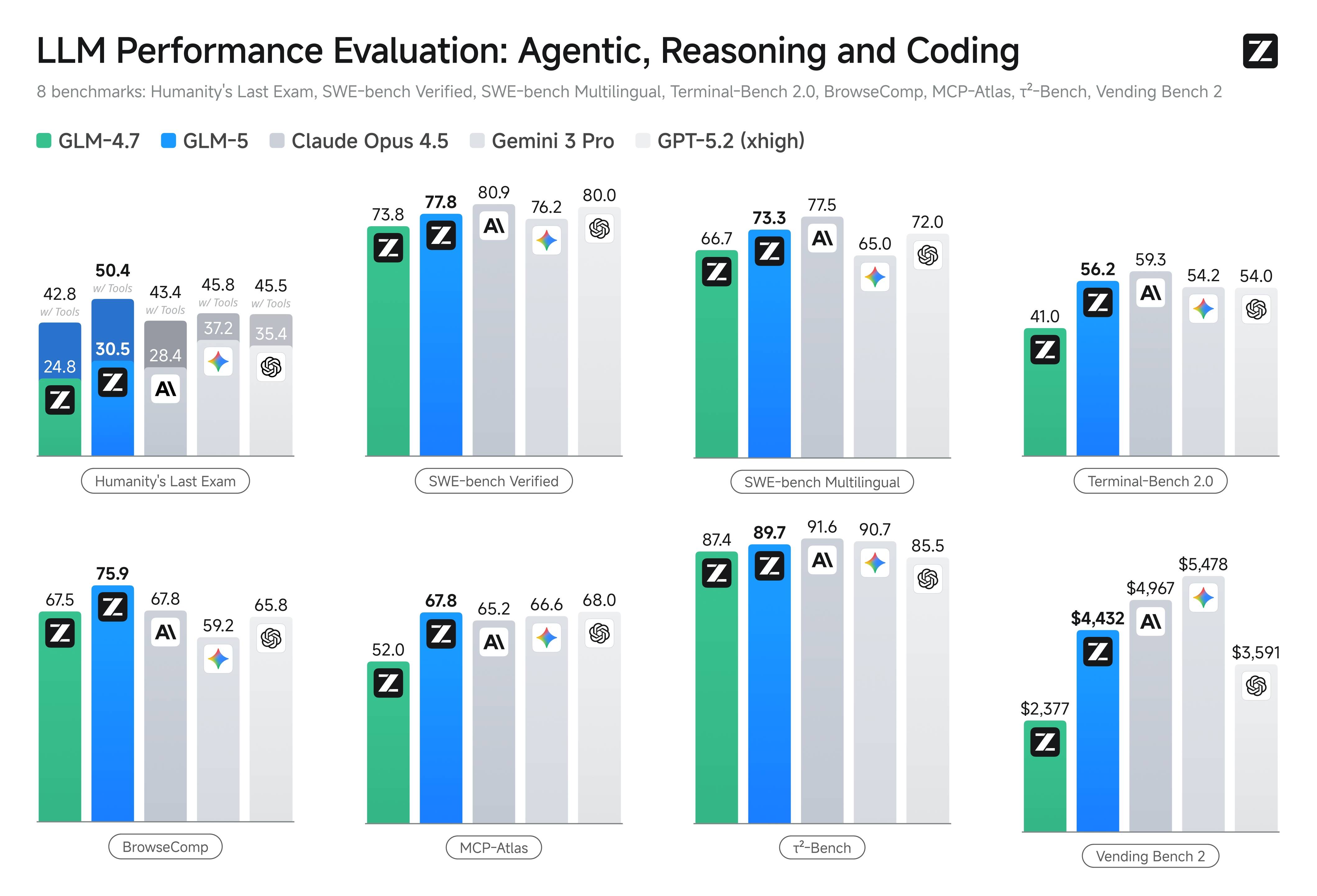

GLM-5 模型在 SWE-bench Verified 上得分 77.8,跻身 2026 年顶级编码模型之列。对于专门的编码工作负载,智谱 AI 还提供 GLM-5-Code,一个为软件工程任务优化的专用变体。GLM-5 code 性能覆盖多个维度:

- 代码修复: GLM-5 能识别和修复真实代码库中的 bug,经 SWE-bench Verified benchmark 验证

- 多语言编码: SWE-bench Multilingual 得分 73.3,GLM-5 有效处理 Python、JavaScript、TypeScript、Java、Go 等语言

- 终端操作: Terminal-Bench 2.0 得分 56.2,表明 GLM-5 能可靠地组合和执行命令行工作流

- 工具编排: MCP-Atlas 得分 67.8,展示 Agent 编码工作流必需的多步工具链能力

连接 GLM-5 API

GLM-5 API 兼容 OpenAI,你可以使用标准 OpenAI SDK 并修改 base URL。以下是 TypeScript 中的基本 GLM-5 code 集成示例:

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: process.env.ZAI_API_KEY,

baseURL: 'https://api.z.ai/api/paas/v4/',

});

const completion = await client.chat.completions.create({

model: 'glm-5',

messages: [

{ role: 'system', content: '你是一位高级软件工程师。编写简洁、有测试的代码。' },

{ role: 'user', content: '将这个函数从回调重构为 async/await。' },

],

temperature: 0.1,

max_tokens: 4096,

});

console.log(completion.choices[0]?.message?.content);Python 开发者的 GLM-5 code 集成遵循相同模式:

from openai import OpenAI

client = OpenAI(

api_key="your-zai-api-key",

base_url="https://api.z.ai/api/paas/v4/"

)

response = client.chat.completions.create(

model="glm-5",

messages=[

{"role": "system", "content": "你是一位高级软件工程师。"},

{"role": "user", "content": "为这个认证模块编写单元测试。"}

],

temperature=0.1

)

print(response.choices[0].message.content)GLM-5 Function Calling 编码工作流

GLM-5 code 能力中最强大的是支持并行执行的 Function Calling。这让 GLM-5 能同时调用多个工具,对于需要读取文件、运行测试、检查日志和协调修改的 Agent 编码工作流至关重要。

以下是使用 Function Calling 的 GLM-5 code 示例:

const tools = [

{

type: 'function',

function: {

name: 'read_file',

description: '读取文件内容',

parameters: {

type: 'object',

properties: {

path: { type: 'string', description: '文件路径' }

},

required: ['path']

}

}

},

{

type: 'function',

function: {

name: 'run_tests',

description: '运行测试套件并返回结果',

parameters: {

type: 'object',

properties: {

test_path: { type: 'string', description: '测试文件或目录' }

},

required: ['test_path']

}

}

}

];

const response = await client.chat.completions.create({

model: 'glm-5',

messages: [

{ role: 'user', content: '读取认证模块及其测试,然后给出改进建议。' }

],

tools,

tool_choice: 'auto'

});GLM-5 可以在单个响应中发出多个函数调用,实现并行文件读取、并发测试运行和批量 API 查询。与顺序工具调用相比,这种并行执行能力显著降低了多步 GLM-5 code 工作流的延迟。

GLM-5 与 GLM-5-Code 变体对比

根据官方最新定价页,智谱 AI 提供专用的 GLM-5-Code 变体,定价为每百万输入 token $1.20、每百万输出 token $5.00。GLM-5-Code 变体专为软件工程任务优化,在复杂重构、测试生成和架构决策方面可能产生更高质量的输出。

选择标准 GLM-5 还是 GLM-5-Code 时,考虑以下因素:

- 标准 GLM-5 对通用编码任务、代码审查和文档生成更经济,质量差异可能不大

- GLM-5-Code 推荐用于复杂重构、多文件修改和首次通过率直接影响开发效率的任务

- GLM 系列中的低成本模型 适用于成本优先的开发和测试环境

GLM-5 生产编码工作流

生产环境的 GLM-5 code 部署,遵循以下可靠性模式:

中间件重试: 在中间件层添加瞬态 API 错误的重试逻辑。GLM-5 code 请求在高峰负载时可能偶尔超时,带指数退避的自动重试可防止工作流中断。

输出验证: 在应用变更前验证 GLM-5 code 输出。对生成的代码运行 linter、类型检查和测试套件,在问题到达生产前捕获。

人工审批关卡: 对于数据库迁移、部署脚本和基础设施变更等不可逆操作,在人工审批后再执行 GLM-5 code 输出。

上下文管理: 对于大型代码库,精心策划发送给 GLM-5 的上下文,而非整个仓库倾倒。200K 上下文窗口虽然宽裕,但聚焦的上下文比散乱的倾倒能产生更好的 GLM-5 code 输出。

GLM-5 Code 上线前检查清单

将 GLM-5 code 工作流部署到生产前,完成以下评估清单:

- 构建涵盖 bug 修复、重构、测试生成和文档的代表性编码评测集

- 用相同提示词对 GLM-5 和当前模型运行每种任务类型

- 追踪成功率、重试率、延迟和每任务成本

- 验证你特定工具定义的 Function Calling 可靠性

- 用实际代码库大小测试上下文窗口限制

- 在不同温度设置下验证输出质量

- 测量包含工具调用往返在内的端到端工作流延迟

这种系统化评估将让你对 GLM-5 code 在你特定工程工作流中的能力充满信心,并帮助识别需要额外处理的边缘情况。